- OpenAI a klíčové oborové organizace oznámily spolupráci na ochraně hlasu a podoby v generovaném videu

- Sora nově blokuje generování celebrit bez výslovného souhlasu a slibuje rychlejší vyřizování stížností

- Pro držitele práv se chystají mnohem větší možnosti kontroly a nastavení i model sdílení příjmů za využití postav

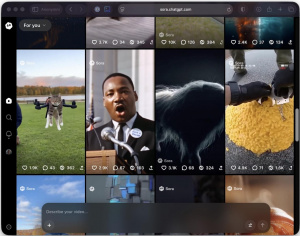

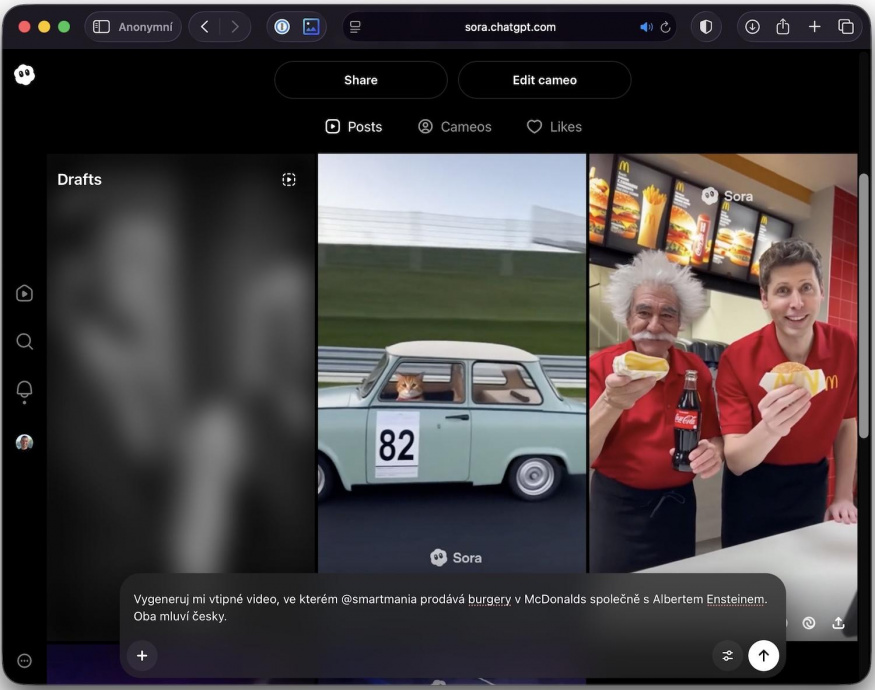

OpenAI zpřísnila pravidla pro svou videoaplikaci Sora poté, co se objevily případy neautorizovaných deepfake videí s podobou známých osobností. Firma společně se SAG-AFTRA, hercem Bryanem Cranstonem, agenturami UTA a CAA a Asociací talentových agentů (ATA) vydala prohlášení o „produktivní spolupráci“ na ochraně hlasu a podoby v obsahu vytvářeném v Soře. Změny přímo reagují na stížnosti Cranstonovy i rodin Robina Williamse, George Carlina a Martina Luthera Kinga Jr.

In, nebo out?

Dosavadní režim „opt-in“, tedy využití hlasu či podoby žijící osoby pouze se souhlasem, se ukázal jako nedostatečný, protože někteří uživatelé dokázali ochranu obejít. OpenAI proto posílila pravidla a výslovně zakázala generování videí s celebritami bez předchozího, doložitelného souhlasu. Společnost zároveň přislíbila, že na nahlášené případy bude nově reagovat „určitě a bezodkladně“.

Další úpravy se týkají historických a veřejně známých postav. OpenAI uvádí, že uznává „silný veřejný zájem a svobodu projevu“ u zobrazení zesnulých osobností, ale umožní oprávněným zástupcům či správcům pozůstalostí požádat o vyloučení jejich podoby ze Sory. Firma ostatně už minulý týden upravila chování aplikace po stížnosti rodiny Martina Luthera Kinga Jr. a slíbila robustnější ochranu u historických figur.

Altman se obhajuje

K tématu se vyjádřil i šéf OpenAI Sam Altman, který avizoval dvě blízké novinky. Za prvé, držitelé práv mají získat mnohem větší kontrolu nad generováním svých postav, a to nad rámec současného opt-inu, včetně možnosti přesně vymezit, jak lze danou postavu používat, nebo využití úplně zakázat.

Altman dodal, že se očekávají různé přístupy jednotlivých subjektů a že systém se bude rychle upravovat a ladit. Za druhé, OpenAI hledá udržitelné financování generování videí a plánuje sdílet část příjmů s držiteli práv, kteří povolí fanouškovské generování jejich postav; přesný model se má vyvíjet postupně.

Sora od svého spuštění 30. září rychle získala popularitu v App Storu, což zvýšilo tlak na jasná pravidla proti zneužívání podobizen a hlasů. Zpřísnění ochranných mechanismů má omezit reputační i právní rizika spojená s deepfaky, zároveň ale také ponechat prostor pro legitimní kreativní tvorbu a „interaktivní fan fiction“, o něž podle OpenAI projevují mnozí držitelé práv značný zájem.

Odpuštění, ne povolení

Otevřenými otázkami zůstává, jak přesně se bude ověřovat souhlas, jak budou fungovat výjimky u veřejně známých postav a jaký ekonomický model sdílení příjmů si trh osvojí. A jak tohle všechno vlastně může projít. OpenAI deklaruje vysoké tempo dalších úprav a slibuje, že ověřené postupy ze Sory následně uplatní napříč svými produkty.

Nepřehlédněte

Sora generuje neskutečná videa, ale jen vyvoleným. Poradíme, jak získat přístup (návod)

Vtip je ale v tom, že se nám tady zas a znova opakuje dnes už asi bohužel typický scénář ze Silicon Valley – právní stránka se neřeší vůbec nebo až zpětně. Namísto povolení tak nyní Altman žádá o odpuštění a o spolupráci. A prakticky to tak vypadá, že si OpenAI může dělat úplně cokoliv, co se jí zamane. Ne snad že by na firmu nemířila jedna žaloba za druhou, nicméně právní spory stále ani náhodou neodpovídají údajnému rozsahu potenciální „krádeže“, využívání a monetizování cizího obsahu.