- Nahráli jste někdy na sociální sítě nějaké video s vaší osobou, které je delší než 1 minuta?

- Právě tak krátký obrazový a zvukový záznam dnes stačí k tomu, aby vám AI vytvořila vaši kopii

- Útočníci mohou takto získané video využít k trestné činnosti

Instagram, TikTok, Facebook a další… Sociální sítě, do kterých se denně přihlašujeme, využíváme je a jsou zdarma. Přichází ovšem doba, kdy se data na sociálních sítích dají využít nejen ke správnému zacílení reklamy na vaši osobu, ale také k jejímu přímému poškození. Z minutového videa, které jste nahráli na některou ze sociálních sítí, nebo klidně z videohovoru přes FaceTime či WhatsApp, lze poměrně snadno vytvořit AI avatara, který vypadá a mluví jako vy.

Ve světě aktuálně rezonuje jen několik dní stará kauza, kdy podvodníci zinscenovali falešný videohovor s jedním ze zaměstnanců mezinárodní firmy, během kterého se vydávali za finančního ředitele a další členy představenstva. Kromě e-mailové komunikace a WhatsAppu (zprávy + video) útočníci využili i videokonference. Díky tomu dotyčného zaměstnance „donutili“ v rámci patnácti bankovních převodů převést částku 25,6 milionu dolarů, což je zhruba 595 milionů korun. Případ nyní vyšetřuje hongkongská policie, která již zatkla šest osob. Jméno společnosti ale z pochopitelných důvodů zveřejněno nebylo.

Co je to AI avatar?

Většina z nás již nejspíše viděla jakási pseudo deepfake videa, kde nějaká známá osobnost říká svým hlasem nějaká naprosto nesmyslná prohlášení a ústa se jí nepohybují tak, jak by měla. Tomu se říká AI dubbing a největší překážkou k jeho vytvoření je akvizice cca minutové nahrávky hlasu osoby, kterou chcete kompromitovat. V České republice se obětí tohoto útoku minulý týden stal ministr vnitra Vít Rakušan, ale bude jich přibývat.

AI avatar je o krůček dál. Ten je schopen mrkat, dýchat, hýbat ústy a pohybovat se naprosto přirozeně v kontextu toho, co říká. Co je třeba k tomu, aby si kdokoliv mohl vytvořit takového avatara? Se standardně dostupnými nástroji, bez větších IT znalostí je to jedno jediné video, které nemusí být delší než 2 minuty… Zkušenější uživatel to zvládne dokonce i s minutovým videem. A skuteční profíci zvládnou rozpohybovat i fotku, kterou získali třeba z vašeho profilu na Facebooku či z firemního webu.

V tuto chvíli se můžete myšlenkou vrátit na začátek článku, zkontrolovat si sociální sítě a položit si otázku: „Existuje někde nějaký můj videozáznam, kde jsem v detailním záběru déle než minutu? Existuje někde moje portrétová fotka?“ U většiny z nás je odpověď na tuto otázku „ano“. A tím pádem se snadno můžeme stát terčem útoku. Odcizení vaší digitální identity se díky příchodu AI stalo ještě větší hrozbou.

Zneužití vaší identity v praxi

Pojďme si nyní výše popsané ukázat na „reálném“ příkladu společně s časovou osou. Ještě než začneme, upřesním, že veškeré záběry vzniklé pro potřeby tohoto článku byly vytvořeny se souhlasem účinkujících osob.

Upozornění: V článku nejsou záměrně uvedeny všechny kroky a text v žádném případě nemá nabádat k podvodné činnosti. Chceme pouze upozornit na to, jak jednoduché v dnešní době je zneužít vaši identitu prostřednictvím videozprávy, hovoru či veřejně dostupných dat ze sociálních sítí a vytvořit kopii vašeho hlasu, nebo rovnou video s vaší osobou.

Postup v článku není ze zřejmých etických důvodů kompletní a v době vydání článku již není funkční – služby ElevenLabs a HeyGen, které jsou v článku zmíněny, se proti zneužívání dat snaží bojovat a neustále přidávají další ochranné mechanismy, aby případným útočníkům co nejvíce ztížily jejich aktivitu. Jak tyto ochranné mechanismy obejít, samozřejmě zveřejňovat nebudeme.

Je 12:23 a já posílám kolegovi v práci rychlou videozprávu o průběhu meetingu, kterou si můžete přehrát ve vloženém videu. Ač se může zdát, že se jedná o nevinný obsah, je toto zcela dostačující, dokonce až perfektní obsah k vytvoření AI avatara.

1. krok: získání hlasu

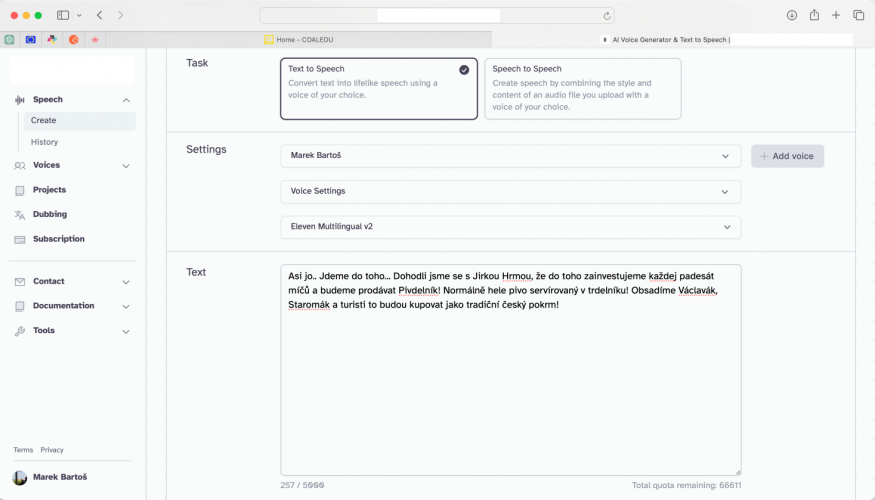

Pracuji na macOS. K získání zvukové stopy jsem proto použil nativní aplikaci GarageBand. Postačí vám ale samozřejmě jakýkoliv jiný nástroj schopný z videa extrahovat zvukovou stopu. Tu jsem uložil do formátu MP3.

Zapnete nativní aplikaci GarageBand a video vložíte do časové osy a uložíte jako MP3. Následně ve webovém prohlížeči otevřete aplikaci ElevenLabs a izolovanou zvukovou stopu importujete. Během pár vteřin tak máte k dispozici věrohodnou repliku hlasu.

Vytvořená replika, kterou si můžete poslechnout v přehrávači nad tímto odstavcem, se dá velmi snadno zneužít k poškození vaší osoby, případně vašich blízkých… Zde je jednoduchý příklad.

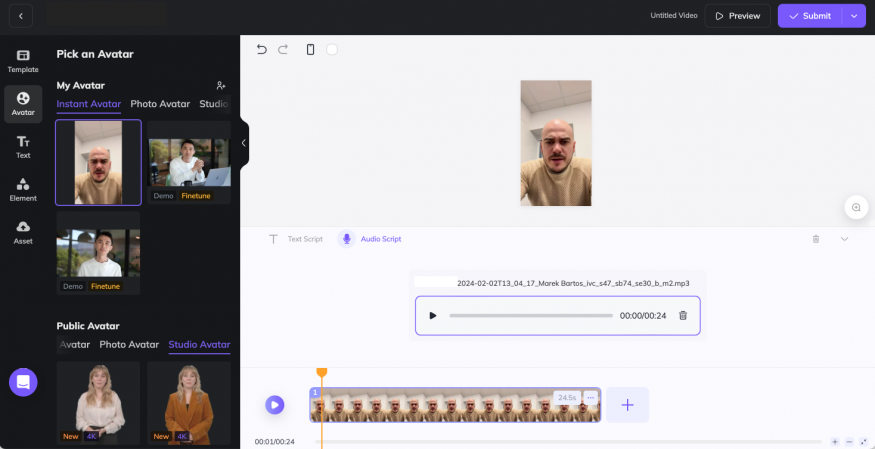

2. krok: vytvoření virtuálního „avatara“

Pokud mě bude chtít kolega skutečně poškodit, nebo si ze mě jenom udělat legraci, může avatarovi dát i mou tvář. Zde už je postup (naštěstí) o něco složitější, ale i tak to nezabere déle než pár minut. Opět online otevřu aplikaci, nemusím nic instalovat. Samotná webová aplikace HeyGen pro tvorbu virtuálních avatarů není nijak závadná a tvůrci se proti zneužití snaží aktivně bojovat.

Otevřu možnost tvorby avatara a importuji celé video tak, jak bylo zaslané, bez žádné změny. Aplikace bude video chvíli přechroustávat a následně vás požádá o upload souhlasu s použitím osobních záběrů. To se může zdát jako menší problém, protože daná osoba žádný takový souhlas nevydala, nicméně i toto dokáže vyřešit volně dostupná a zcela legální online služba, jejíž název ale záměrně neuvádíme. Stačí vložit fotku vystřiženou z původního videa, v Elevenlabs si vygenerovat AI hlasem znění souhlasu a tadá – ve 12:47 je souhlas na světě. Vypadá přesně takhle a je až šokující, jak tragická kvalita je dostačující.

Tento souhlas tedy nahraji do tvorby avatara a nyní mohu donutit říct postiženou osobu naprosto cokoliv. Toto je výstup, který vznikl ve 13:15, tedy zhruba tři čtvrtě hodiny po obdržení videa.

Reálná situace

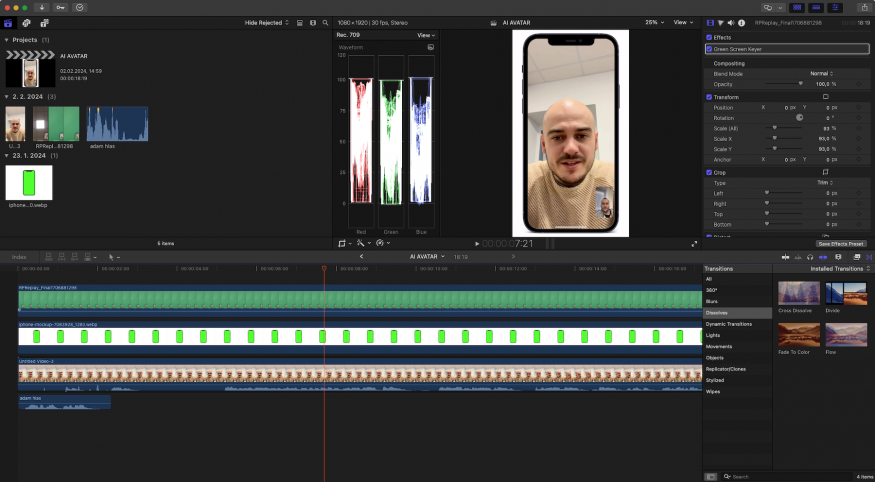

A teď už jen zbývá vytvořit si reálnou situaci, kdy by bylo reálné, že se vám někdo s něčím svěří. Ideální je pro tyto potřeby třeba hovor skrze již zmíněný FaceTime nebo jinou komunikační platformu podporující videohovory.

Stačí si tedy vygenerovat v Eleven Labs text, který chcete, aby avatar říkal. Následně ho vložit jako hlasový zdroj pro avatara, vygenerovat avatara a nahrát si obrazovku telefonu při imaginárním telefonátu. V iMovie, Final Cutu nebo jakémkoliv programu pro střih videa už jen jednotlivé materiály stačí dát dohromady.

Výsledek pak může vypadat následovně – my jsme vytvořili podvodný FaceTime záznam hovoru, ve kterém se dozvíte o plánech, které chystáme s Jirkou Hrmou, šéfredaktorem SMARTmania.cz… :-) Je 13:30 a my máme hotovo. Celý proces tedy nezabral ani celou hodinu.

Jak se bránit?

A teď co s tím? Jak se proti těmto praktikám vůbec bránit a je skutečně reálné ochránit vaši osobu před zneužitím? V první řadě je dobré být obezřetný a ověřit si, jaká videa nahráváte na sociální sítě, případně zda je obsah veřejně dostupný.

Ač se naše pokusné video o „pivdelníku“ může zdát humorné, nic mi v tuto chvíli nebrání se pomocí virtuálního avatara „přiznat k čemukoliv“, co si případný útočník usmyslí. Vzít politicky exponovanou osobu a donutit ji říct naprosto cokoliv. Sliby, lži, přiznání… Asi je nám všem zřejmé, že nejrizikovější skupinou pro takový obsah jsou děti a senioři.

Mladí nemají dostatečně kritické oko a pro většinu našich babiček a dědečků je samotná existence tohoto obsahu tak neskutečně nereálná, že ani nejsou ochotni přijmout falešnost videa, které vidí. Naštěstí existují metody, jak obsah generovaný za pomoci AI odhalit a jak naučit ostatní umělou inteligenci využívat takovým způsobem, aby její pozitivní stránky dokázaly předčit ty negativní.

Tématu osvěty a prevence zneužití umělé inteligence se v České republice věnuje čím dál více firem a organizací. Jedním z předních příkladů je společnost coaledu, z.ú., která cílí na kybernetickou bezpečnost a šíření osvěty o možných rizicích spojených s umělou inteligencí, užíváním sociálních sítí a sdílením informací na internetu. V rámci společnosti aktuálně vzniká nová odnož specializující se přímo na AI a osvětu v tomto raketově rostoucím odvětví.

Společnost organizuje širokou škálu osvětových a vzdělávacích akcí, včetně přednášek, workshopů pro studenty i širokou veřejnost či firemní školení. Ty jsou dostupné jak prezenčně, tak i online. Tento článek vznikl s cílem upozornit na rizika krádeže identity, která je s dostupností AI snadnější než kdy dřív. Vychází záměrně dnes (6. února), na Den bezpečnějšího internetu.