- Čínské AI nástroje dál sílí, ukázkou toho je i nový projekt ByteDance

- OmniHuman-1 dokáže rozpohybovat jakýkoliv obrázek, přidá i zvuk či mluvené slovo

- Experti se obávají nové vlny extrémně nebezpečných deepfake videí

Málokoho už překvapí svou kvalitou nástroje generativní AI, které umí skvěle napsat celou diplomovou práci nebo navrhnout fotorealistický obrázek. Stále celkem neprobádaným územím jsou však AI modely specializující se na tvorbu videí. Viděli jsme, co dokáže Sora od OpenAI nebo v mnoha ohledech ještě lepší VASA-1 od Microsoftu. Na to všechno ale můžete zapomenout, zcela novou dimenzi totiž dává tomuto segmentu čínská AI OmniHuman-1.

OmniHuman: děsivě realistická AI videa

Za umělou inteligencí OmniHuman-1 stojí původně čínská společnost ByteDance, matka CapCutu, kontroverzní sociální sítě Douyin a jejího globálně dostupného sourozence TikTok. Základní stavební kámen jejího nového AI projektu je přitom primitivní: libovolný přiložený obrázek dokáže rozpohybovat, přidat pozadí, zvukovou stopu (hudbu nebo i mluvené slovo) a s ní sesynchronizovat pohyb rtů.

Ačkoliv tvůrci prezentují kvality svého nástroje na neškodných kreslených postavičkách, problém je někde úplně jinde. Stejně precizně totiž umí OmniHuman zpracovat i obrázek člověka, opatřit jej extrémně realistickými pohyby obličejových svalů, ale také gesty rukama a podobně. Naprosto fascinující a zároveň děsivé příklady zachytil na svém videu youtubový kanál SECourses.

Nepřehlédněte

Pozdě, ale přece! Evropská unie se probrala a začíná vyvíjet vlastní umělou inteligenci

Podle serveru Business Standard využili inženýři ByteDance k tréninku své AI OmniHuman zhruba 19 000 hodin video záznamu, přičemž není znám původ těchto záběrů. Umělá inteligence nejprve komprimuje data o pohybu z různých vstupů a poté je zpřesňuje porovnáváním vygenerovaných videí se skutečnými záběry. „Díky tomuto dvoufázovému procesu dokáže OmniHuman-1 vytvářet velmi přesné pohyby úst, výrazy obličeje a gesta těla, takže konečný výstup vypadá přirozeně,“ vysvětluje Business Standard.

Deepfake na vzestupu?

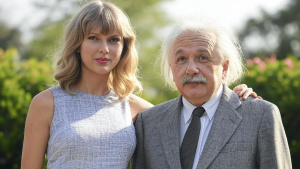

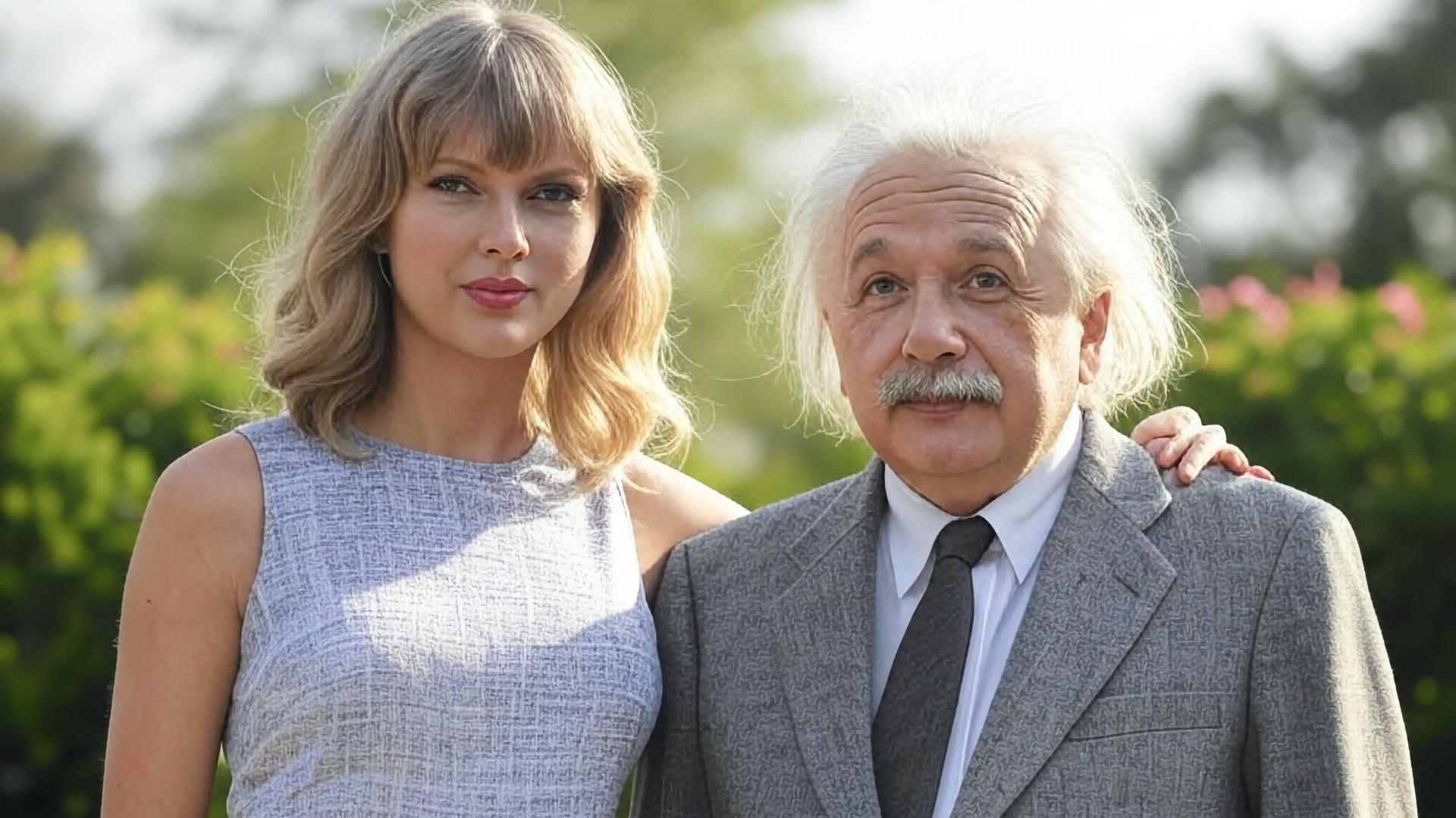

V přiložených ukázkách můžete vidět rozpohybované skutečné řečníky z konferencí TED Talks, Alberta Einsteina gestikulujícího před tabulí, rapujícího šéfa Nvidie nebo Taylor Swift zpívající znělku z japonského seriálu Naruto. Právě ty s americkou zpěvačkou z internetu promptně mizí. Prohlédnout si je ale můžete v přiloženém vláknu od @CodeByPoonam na síti X, kde prakticky žádná regulace obsahu v tuto chvíli uplatněna není.

5. Some of the demos are officially erased pic.twitter.com/v1Lao4hqOQ

— Poonam Soni (@CodeByPoonam) February 5, 2025

Z pochopitelných důvodů vzestup podobných AI služeb děsí především experty na kybernetickou bezpečnost. S podobným nástrojem je vytvoření extrémně věrohodného deepfake videa otázkou pár minut. Na etickou problematiku upozorňují i tvůrci v dokumentu, který spolu s OmniHuman zveřejnili. „Obrázky a zvuky použité v těchto ukázkách pocházejí z veřejných zdrojů nebo jsou generovány modely a slouží výhradně k demonstraci možností této výzkumné práce,“ stojí ve strohém vyjádření.

Lze tak očekávat, že s masivní expanzí této a dalších podobných AI služeb dojde i ke zpřísnění regulace na úrovni jednotlivých trhů. Evropská unie (EU) již vloni v květnu schválila obsáhlý balíček zvaný AI act, který si dává za cíl alespoň částečně regulovat to, jak jsou AI nástroje používány. Nástroje replikující skutečné osobnosti, včetně politiků, jako je právě OmniHuman, mohou spadat do nejpřísnější kategorie a mohly by být hned zkraje platnosti eurounijního zákona zakázány. Soubor AI act však stejně začne platit až v roce 2026.