- Nvidia uvolnila nástroj Audio2Face jako open source, včetně SDK

- Systém převádí akustické rysy řeči na mimiku, přesný lip-sync a emoční výraz v reálném čase i offline

- K dispozici jsou pluginy pro Mayu a Unreal Engine 5 i nové modely (regression 2.2, diffusion 3.0; Audio2Emotion 2.2/3.0)

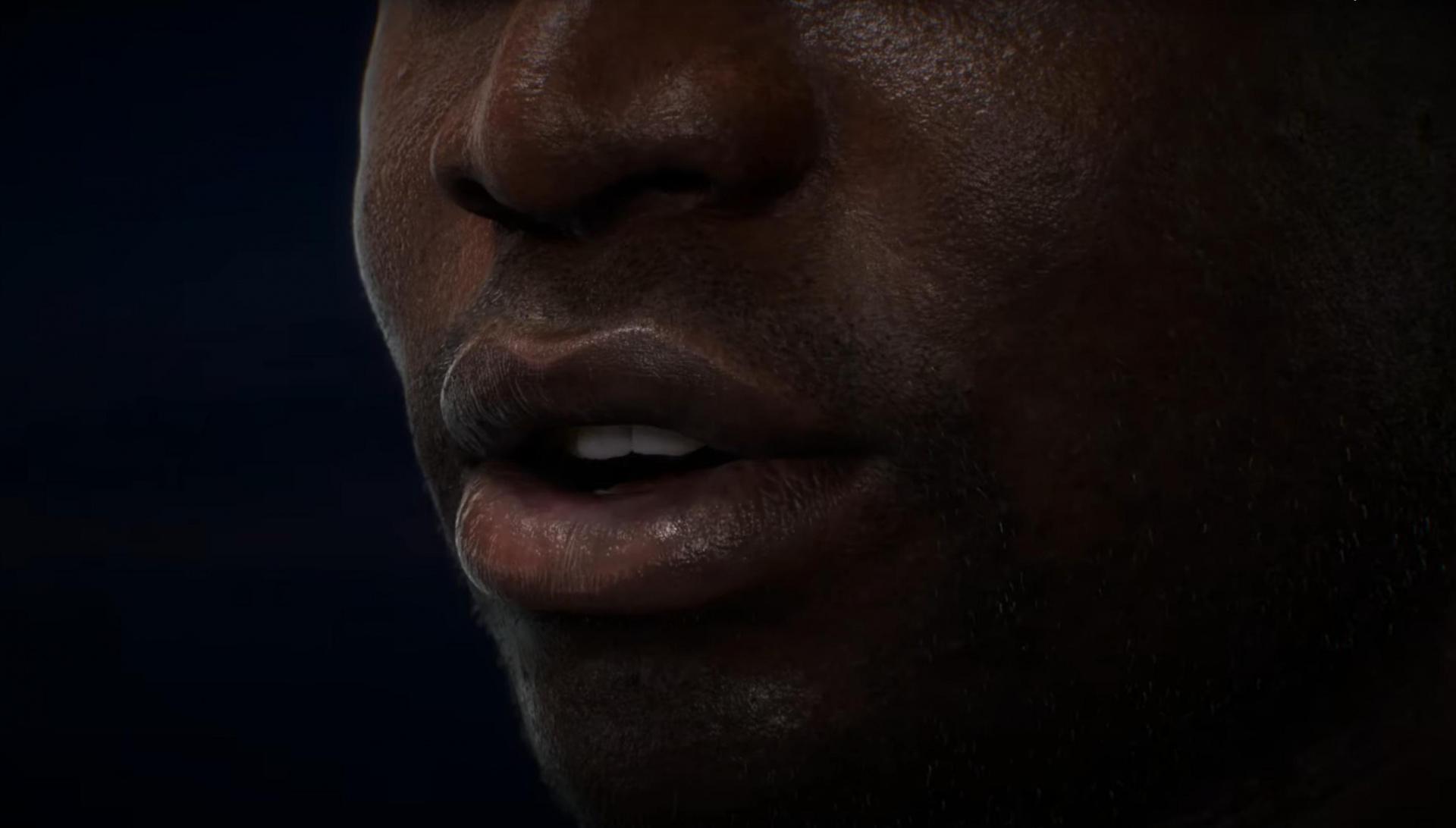

Nvidia zpřístupnila svůj nástroj Audio2Face, který pomocí umělé inteligence převádí zvuk na detailní mimiku 3D postav. Kromě samotných modelů firma zároveň uvolňuje i software development kit (SDK) a kompletní tréninkový rámec, takže vývojáři mohou technologii rovnou nasadit nebo ji upravit pro vlastní potřeby. Cílem je zrychlit vývoj AI postav ve hrách a 3D aplikacích napříč různými odvětvími.

Stačí trocha hlasu

Audio2Face analyzuje akustické rysy řeči (např. fonémy, intonaci či tempo) a generuje proud animačních dat, který mapuje na předdefinované pózy obličeje. Výsledkem je tak poměrně přesná synchronizace rtů a výrazů, kterou lze renderovat i offline pro předskriptovaný obsah nebo streamovat v reálném čase pro interaktivní postavy a živá vysílání. Technologie má podle Nvidie pokrýt jak přirozenou artikulaci, tak emoční odstíny projevu.

Balík otevřeného kódu zahrnuje Audio2Face SDK s dokumentací pro běh na zařízení i v cloudu a referenční pluginy: Autodesk Maya a Unreal Engine 5. Součástí je taky tréninkový rámec a ukázková data, která umožní tvůrcům studovat celou pipeline a rychle spouštět vlastní učení.

Nvidia zároveň zpřístupňuje generativní modely pro lip-sync, tedy pro technologii, díky které mohou pohyby rtů sedět do mluveného slova. A k mání je také nástroj Audio2Emotion, který z audia odhaduje emoční stav.

Velký posun pro hry

Technologie už našla uplatnění v praxi. Studio Survios ji nasadilo v Alien: Rogue Incursion Evolved Edition, kde zefektivnila workflow pro lip-sync a snímání obličejů, a The Farm 51 ji integrovalo do Chernobylite 2: Exclusion Zone s cílem urychlit tvorbu detailních animací. Další využití pak zahrnuje integrace do her a produktů u společností jako Convai, Codemasters, GSC Game World, Inworld AI, NetEase, Reallusion, Perfect World Games, Streamlabs či UneeQ Digital Humans.

Z open source nátury projektu mohou těžit všichni nejen v herním průmyslu. Vývojáři, studenti i výzkumníci mohou přidávat funkce, optimalizovat výkon pro různé platformy a jemně ladit modely na specifické jazyky, žánry i stylizace. V kontextu rychle rostoucího využití generativní AI ve hrách, médiích a zákaznických službách má Audio2Face snížit náklady a čas potřebný k vytvoření věrohodných digitálních postav. Od krátkých cut-scén až po interaktivní, mluvící NPC řízené AI.

Nejde jen o hry

Rozšíření otevřeného Audio2Face může urychlit i nasazení „digitálních pracovníků“ mimo hry. V zákaznické podpoře a samoobslužných kioscích mohou real-time avataři plynule mluvit s klienty, přesně artikulovat v mnoha jazycích a pomocí Audio2Emotion adaptovat výraz i tón komunikace na základě detekované emoční zátěže. Podobně ve vzdělávání a firemním e-learningu lze rychle generovat lokální verze lektorských videí s věrohodným lip-syncem bez nákladného natáčení různých verzí.

Nepřehlédněte

AI vyrábí 3 000 podcastů týdně. Jeden díl vyjde na dolar a vydělává už po 20 přehráních

Nevyhnutelný je i rozjíždějící se svět virtuálních tvůrců a AI influencerů, který teď ještě zrychlí. Značky si totiž snadněji postaví konzistentní digitální tváře napříč kanály, retail a finance nasadí personalizované průvodce v mobilních aplikacích i na pobočkách. S tím ale přichází i povinné mantinely: transparentní označování AI obsahu, souhlasy s využitím podoby a hlasu, vodoznak či jiné formy označení a transparentní komunikace. Otevřenost sice výrazně snižuje bariéry vstupu a podporuje inovace, zároveň ale taky klade vyšší nároky na odpovědné nasazení a bezpečnostní standardy ve firmách.