Mediální společnost Vice Media, respektive jejich značka Motherboard, nedávno zveřejnila obsáhlou analýzu toho, jak funguje moderování obsahu na Facebooku. Obsah nějakým způsobem koriguje snad každá sociální síť, avšak měřítko, v němž se s moderováním, či chcete-li cenzurou, musí vypořádávat Facebook, je skutečně obrovské. Objem analyzovaných dat snad může být srovnatelný pouze s YouTube.

Analýza Vice vychází z rozhovorů se současnými i bývalými zaměstnanci společnosti, z uniklých interních dokumentů, z konkrétních kauz a z názorů odborníků. V dnešním článku se vám ve zjednodušené podobě pokusíme přiblížit, s čím vším se Facebook musí každodenně potýkat. A vězte, že mnohdy dochází ke skutečně paradoxním situacím.

Začalo to „selským rozumem“

Dave Willner, současný šéf obsahové strategie Airbnb byl jedním z prvních, kdo měl ve Facebooku moderaci na starost. Když vzpomíná na začátky Facebooku, mluví o tom, že moderování obsahu tehdy nebylo nijak náročné. Facebook byl stále víceméně sítí pro studenty a většinu času tak prý šlo pouze o odstraňování nahých fotografií a příležitostné mazání spamu či phishingu. Tehdejší pravidla se prý vešla na jedinou stránku formátu A4 a dala by se shrnout do věty: „Hitler je špatný a stejně tak je špatné nemít na fotografii kalhoty“.

Ještě v roce 2009 byl moderační tým Facebooku pouze dvanáctičlenný, což na tehdejších 120 milionů uživatelů vcelku stačilo. Jak však popularita sítě začala pronikat hlouběji mimo americké hranice, moderátoři museli čím dál tím častěji řešit závažnější problémy. První velkou zkouškou pravidel byl červen 2009. Tehdy bylo na sociální síť nahráno video vraždy šestadvacetileté studentky Nedy Agha-Soltan z Íránu. Tu na ulici Teheránu zastřelily islamistické milice Basídž věrné režimu, proti němuž studentka spolu s dalšími kvůli zmanipulovaným volbám protestovala. Ačkoliv video by teoreticky vzhledem ke svému násilnému obsahu mělo být smazáno, vedení Facebooku se ho rozhodlo na platformě ponechat. Tato událost předznamenala současný stav, kdy se musí moderátoři pravidelně vyrovnávat se spornými příspěvky a individuálně řešit jejich přínosnost.

Iluze celosvětové komunity

Facebook do dnešního dne operuje s jakousi vizí velké globální komunity uživatelů, kteří sdílí stejné ideály a zásady. Proto se snaží svá pravidla konstruovat globálně a tak, aby fungovala přes hranice. Je však zjevné, že pravidla funkční pro USA nemusí úplně dobře fungovat v třeba Pákistánu a naopak. Pravidla jako taková navíc nejsou jediným problémem, vnímání jednotlivých příspěvků se značně liší i mezi moderátory, a to nejen kvůli jejich názorovým odlišnostem, ale také kvůli kulturním rozdílům.

Princip rozhodování moderátorů dle vlastní úvahy tak musel být s rozšířením do více zemí zrušen. Facebook prováděl A/B testování moderátorů. Výsledek ukázal, že se jednotliví moderátoři v názorech na konkrétní příspěvky často velmi zásadně liší. Proto jsou dnes vytvářeny velmi podrobné příručky a manuály, podle nichž musí pří řešení nahlášených příspěvků zaměstnanci postupovat. I přes snahu přijít s co nejvíce systémovým řešením eliminujícím subjektivní názory moderátorů však určitý lidský prvek zůstává. Někdy se totiž například může překrývat více důvodů pro odstranění příspěvku a moderátoři musí vybrat pouze jeden.

Mimochodem, výkony moderátorů jsou interně hodnoceny a pokud jejich skóre klesne pod 98% správnost určení, mají problém. Podle některých zdrojů ze společnosti značná část moderátorů na své pozici nevydrží ani rok. Kromě technické náročnosti je totiž práce samozřejmě velmi náročná i psychicky. Pravidelně prohlížet nenávistné, násilné či pornografické příspěvky totiž určitě není práce pro každého.

Personalizovaná budoucnost podle Zuckerberga

Server Motherboard získal od několika zaměstnanců Facebooku otevřený dopis zakladatele Zuckerberga, týkající se jeho vize moderování obsahu. Navzdory obecným frázím o globální komunitě v něm nastiňuje budoucí koncept, kdy si každý uživatel bude moci nastavit pravidla podle sebe.

Personalizované filtrování obsahu by mělo fungovat přibližně tak, že budete mít u každého jevu několikastupňový posuvník. Nastavíte si tak pro vás přijatelnou hranici násilí, nahoty, sprosté mluvy a podobně. Umělá inteligence následně bude váš feed příspěvků filtrovat podle vašich pravidel. Pravidla se navíc budou v závislosti na regionu jaksi průměrovat a podle nich se bude určovat výchozí nastavení pro nové uživatele v dané geografické oblasti. Zcela zakázaný pak bude ten obsah, který je extrémnější než nejbenevolentnější možné nastavení. Sám Zuckerberg tuto vizi v interním emailu označuje jako „masový demokratický proces pro určení standardů a jejich vynucování AI“.

Koncept je to zajímavý a určitě by do jisté míry mohl vyřešit regionální a kulturní rozdíly mezi uživateli. Technologie pro to však ještě nejsou připravené, což přiznává i sám Zuckerberg. Zřejmě i proto jsou v dokumentu stále věty o „budování dlouhodobé sociální komunity, která spojí lidstvo“.

Byznys je byznys

Vzletné fráze však musí stranou, když přijde na byznys. Jedna věc jsou totiž kulturní odlišnosti, druhou jsou pak konkrétní legální požadavky jednotlivých zemí. A tak podle interních dokumentů musí například moderátoři v Indii a Pákistánu zachytávat příspěvky urážející Alláha. Takovéto příspěvky jsou předány k individuálnímu posouzení speciálnímu oddělení Facebooku zabývajícímu se splňování národních požadavků států.

Ačkoliv blokování takovýchto příspěvků zcela zjevně porušuje svobodu slova deklarovanou Facebookem, společnost si nemůže dovolit nechat se na některém trhu zablokovat či se pouštět do dlouhých soudních sporů. Proto v těchto případech musí vyšší zásady ustoupit ekonomickým zájmům společnosti.

Samostatnou kapitolou je pak popírání holocaustu. V USA popírání holocaustu trestné není, neboť zde existuje tradice skutečné svobody slova. I tak však Facebook již několik let čelí kritice, že neblokuje komunitu popíračů holocaustu. Paradoxně je však kritizován zejména samozvanými aktivisty. Již v roce 2009 totiž skupina židovských zaměstnanců Facebooku vystoupila s prohlášením, že ačkoliv je samotné pochopitelně popírání holocaustu uráží, nemyslí si, že by měl Facebook tento obsah blokovat a fungovat jako cenzor.

Některé země včetně České republiky však mají popírání holocaustu definované vyloženě jako trestný čin. Některé z nich navíc aktivně požadují blokování tohoto obsahu, což Facebook do svých interních materiálů promítl. Devět vybraných zemí, mezi nimiž je například Slovensko, tak má blokován přístup k tomuto problematickému obsahu. Blokování je prováděno na základě geografické polohy získané z IP adres uživatelů.

AI není záchrana

Lidští moderátoři musí týdně zpracovat v průměru 10 milionů potenciálně závadných příspěvků. Cílem je pracovat s více než 99% přesností a každý nahlášený příspěvek zkontrolovat do 24 hodin. Jak přesně se to Facebooku daří nevíme, ale podle interních dat stále denně špatně vyhodnotí desetitisíce příspěvků.

V některých oblastech moderátorům práci značně usnadňují firemní AI nástroje. Roboti detekují téměř 100 % spamu, více než 99,5 % teroristicky orientovaných příspěvků, 98,5 % falešných účtů, 96 % pornografického obsahu a 86 % grafického násilí. V těchto případech moderátoři s vyhodnocením takových příspěvků moc práce nemají, neboť AI se zpravidla nemýlí. Detekční systémy se navíc stále učí podle toho, jak s nahlášenými příspěvky pracují moderátoři.

Nejvíce práce tak je s tzv. hate speech, tedy převážně textovými příspěvky obsahujícími slovní útoky na jednotlivce i skupiny. Tyto příspěvky jednak neumí umělá inteligence dobře detekovat (odhalí pouze 38 % smazaných příspěvků) a navíc je velmi závislá na „znalosti“ jazyka. Mimo angličtinu a (poněkud překvapivě) portugalštinu prý není ani dostatek dat pro „výcvik“. I se znalostí jazyka je ovšem velmi těžké strojově porozumět kulturně-sociálním souvislostem, a tak většina příspěvků tohoto typu pochází z uživatelských hlášení a moderátoři jim musí věnovat více času.

Pravidla šitá horkou jehlou

V případě hate speech a obecně problematických vyjádření o sociálně-kulturních jevech je navíc často těžké držet se konkrétních pravidel. Ačkoliv Facebook striktně nutí své moderátory postupovat dle předepsaných vzorců, o nichž bude řeč později, ne vždy to stačí. Uživatelé jsou totiž vždy jaksi napřed a ani dvakrát měsíčně konané porady o nových pravidlech moderace nedokáží dostatečně flexibilně reagovat na nové „trendy“.

Ukázala to například nedávná kampaň #MeToo, v níž ženy obviňovaly často konkrétní muže ze sexuálního obtěžování. Takto cílený útok na určitou osobu totiž samozřejmě pravidlům Facebooku odporoval, zejména těm proti šikanování. Dělat z někoho bez důkazů sexuálního násilníka totiž samozřejmě může mít vážné následky. Na druhou stranu je však třeba vzít v úvahu, že celé hnutí #MeToo mohlo fungovat právě jen díky tomu, že příspěvky na sociálních sítích dodaly odvahu promluvit o své zkušenosti dalším ženám.

V takovýchto krizových situacích musí Facebook urychleně hledat kompromisní řešení dříve, než dojde k nějakému skandálu. V případě menších problémů většinou bývá podle tvrzení zdrojů ze společnosti nějaké pravidlo rychle vytvořeno po debatě ve skupinových emailech a oficiálně je implementováno až zpětně. Když jde však o skutečně závažné události, může být vyhlášen takzvaný „lockdown“.

Jde o stav, kdy jsou ve Facebooku zrušeny všechny meetingy a veškeré schůzky se zaměří pouze na nalezení řešení aktuálně nejpalčivějšího problému. Zpravidla jde o dny až týdny, někdy to však mohou být i měsíce. Když v minulém roce propukl jakýsi trend sebevražedných a sebepoškozujících živých vysílání, trval lockdown celé tři měsíce. Výsledkem bylo přidání moderování živých komentářů, možnost upravit rychlost přehrávání, opakované přehrávání částí videa, textové přepisy videí a mapové znázornění geografické polohy diváctva konkrétního videa. V neposlední řadě také byl zahájen vývoj patřičných AI nástrojů.

Konstantní předcházení krizím

Značná část interních pravidel pro moderátory vzniká ad hoc a často se mění. V některých případech může ke změnám pravidel pro řešení určitého obsahu docházet až několikrát měsíčně, což samozřejmě klade vysoké nároky na školení moderátorů. Facebook se proto snaží všemi silami předcházet tomu, aby pravidla musela vznikat až v průběhu krizových situací.

Jak již bylo řešeno výše, pravidelně se proto konají meetingy o zavádění nových zásad, úpravách těch stávajících a případně odstranění těch již neaktuálních. Redakce serveru Motherboard měla možnost se jednoho z nich zúčastnit. Redaktoři nesměli referovat o konkrétních interních pravidlech přijatých na schůzce, ale dostali možnost zveřejnit její průběh.

Schůze se konají v centrále Facebooku, ovšem skrze videokonferenční hovory je připojeno dalších 11 světových kanceláří firmy. Vybraní experti firmy poté přednesou obecný návrh změn pravidel a zúčastnění o nich následně diskutují. Na závěr schůze je pak schválena určitá změna interních zásad moderátorů. Na jednotlivých pravidlech přijímaných na těchto schůzkách Facebook pracuje týdny až měsíce a konzultuje je s leckým. Oslovováni bývají akademici, neziskové organizace a lobbisté. Podle Petera Sterna, jenž má ve Facebooku komunikaci s těmito organizacemi na starost, prý ale nikdy tyto skupiny netvoří přímo konkrétní pravidla a mají pouze poradní funkci.

Spolupráce s různými skupinami však občas může mít poněkud zvláštní výsledky. Poměrně nedávno například Facebook začal v Austrálii testovat předběžné nahrávání nahých fotografií, které nechcete vidět jednoho dne zveřejněné. Jde o výsledek spolupráce s neziskovkami bojujícími proti tzv. „revenge porn“, tedy zveřejnění intimních fotografií či videí bývalými partnery. Jakkoliv problematické se může (oprávněně) předávání nahých fotografií Facebooku jevit, experti na tuto problematiku tvrdí, že jde o relativně správný postup. Fotografie jsou totiž zablokovány dříve, než jsou nahrány, což je zásadní. Standardně by sice byly brzy detekovány AI nástroji a smazány, ovšem někdo by je již měl šanci vidět a případně uložit.

Fenomén hate speech

Z široké škály jevů, jimiž se moderátoři musí zabývat, je nejvíce fascinující zřejmě moderování „hate speech“. Co je skutečně „za hranou“ a vhodné k odstranění je totiž v tomto případě extrémně diskutabilní a tvorba pravidel je tak velmi složitá. Nechat na jednotlivých moderátorech rozhodování mezi svobodou slova a hate speech by zde bylo zcela neudržitelné. Byly proto vypracovány velmi specifické manuály, které server Motherboard získal. Pochází přímo ze školení moderátorů a jsou pouze graficky změněny, aby byla zachována anonymita zdroje.

Zajímavý je například slide ukazující, jak postupovat v případě podezření z rasistického obsahu. Pokud příspěvek tvrdí, že jsou všichni bílí/černí rasisté, není to problém. Jde zkrátka o názor. Pokud ale v příspěvku napíšete „jsem rasista/násilník“, již pravidla porušujete. Stáváte se tak totiž zástupcem nenávistné skupiny a čeká vás postih.

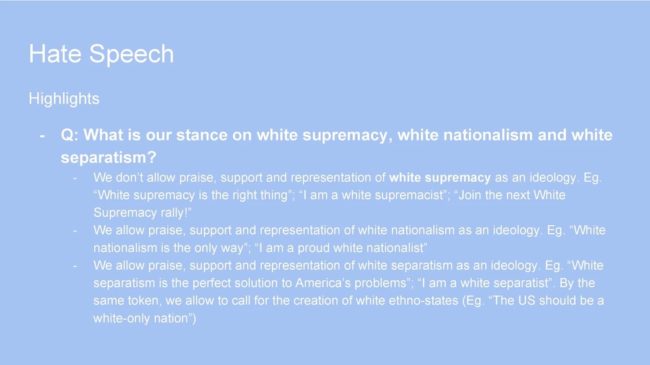

Paradox jménem „bílý nacionalismus“

Pokud vám přišla pravidla týkající se rasismu trochu zvláštní, ta týkající se „bílého nacionalismu“ budou ještě překvapivější. Facebook definuje bílý nacionalismus jako „snahu rozvíjet a zachovávat bílou národní identitu“, což je v podstatě definice z anglické Wikipedie. A jelikož Facebook chrání práva všech ras, musí postupovat stejně i v tomto případě.

Například tedy můžete bez obav napsat, že jste hrdý bílý nacionalista. Do problémů s moderátory Facebooku se nedostanete ani pokud budete tvrdit, že „bílý separatismus je jediným řešením“. V pořádku je dokonce i vyzývat k vytvoření čistě „bílých“ Spojených států. Ve všech těchto případech totiž není explicitně vyjadřována jakákoliv nadřazenost vůči jiným rasám či národům a nedochází ani k žádným útokům na ně. Pravidla navíc musí být podle Facebooku obecná a pokud by bylo zakázané deklarovat vaši náklonnost k bílému nacionalismu, musela by být blokována i hnutí typu Black Lives Matter.

Stačí však změnit jediné slovo a místo white nationalist se začít označovat jako white supremacist. V tomto případě už totiž vyjadřujete nadřazenost jedné rasy a tím porušujete pravidla Facebooku. „Ilegální“ je pak dokonce vyzývat i k účasti na demonstracích rasistických uskupení, či vůbec podporovat myšlenku jakékoliv nerovnosti ras.

Je zcela paradoxní, že volat po vytvoření „bílých“ USA můžete, ale označit sami sebe za rasistu ne. Facebook pro to ale má důvod. Tím je opět jeho snaha vytvářet pravidla aplikovatelná celosvětově. A jak osvětlil mluvčí Facebooku, pokud by byl zakázán bílý nacionalismus, musel by Facebook také blokovat příspěvky vyjadřující podporu sionismu, nebo třeba baskickým či katalánským separatistům.

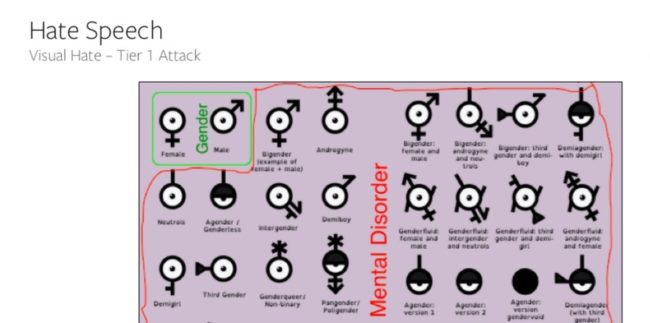

Meme, nebo obrázková nenávist?

Speciální kategorií hate speech jsou obrázky. Často jde o poněkud extrémnější formy memů, někdy jde ovšem samozřejmě o skutečně závadná „díla“. Dvojice příkladů získaných serverem Motherboard ukazuje opět poněkud zvláštní postup Facebooku při řešení nahlášených příspěvků s problematickými obrázky.

Na první grafice vidíme celou řadu symbolů. Symboly pro ženu a muže jsou označeny jako „pohlaví“, zatímco zbylé „identity“ (typu genderfluidní, agenderový…) jsou zařazeny do kategorie „mentální porucha“. Tento obrázek byl vcelku logicky ještě v květnu tohoto roku v souladu s pravidly Facebooku, neboť na nikoho konkrétního neútočí. Pravidla však byla později změněna a tento obrázek již nyní nenahrajete. Důvodem je to, že údajně vyjadřuje nadřazenost dvou pohlaví nad těmi ostatními. Facebook zde zřejmě operuje s tezí, že „gender je sociální konstrukt“ a tedy zpochybňování existence více než dvou pohlaví musí být nutně projevem nenávisti.

Druhá grafika pak zobrazuje karikaturu žida s komiksovou bublinou. V ní se lze dočíst, že židé 11. září 2001 zdemolovali WTC náložemi a následně to svedli na muslimy, přičemž k tomu samozřejmě využili svůj vliv na média. Tento obrázek je na rozdíl od toho předchozího zcela v pořádku. Podle Facebooku prý totiž nijak neuráží oběti 9/11 a jde v podstatě jen o nezávadnou konspirační teorii. Mluvčí Facebooku pro server Motherboard upřesnil, že tento konkrétní obrázek moderátoři často mažou v případě, že je doplněn o nějaký popisek nelichotivě generalizující židy. Například pokud byste tento snímek zveřejnili s popiskem „židé jsou chamtiví“, bude smazán.

Podle čeho Facebook v těchto případech tvořil pravidla, je záhadou. Z vnějšího pohledu se totiž zdá trochu zvláštní, považovat za horší označení biologicky neexistujících pohlaví za mentální poruchu, než obvinění židů ze smrti 3 000 lidí.

Tenká hranice mezi moderací a cenzurou

Moderování obsahu je nutné z morálních, ekonomických i legálních důvodů. Jak se ale stává čím dál tím komplexnějším a důslednějším, začíná se často pohybovat na hraně cenzury. Byť má samozřejmě Facebook jako jakákoliv jiná privátní společnost plné právo cenzurovat cokoliv uzná za vhodné, v poslední době čelí spolu s dalšími platformami kritice zejména v politických otázkách.

Velké sociální sítě obecně jsou kritizovány z obou stran politického spektra. Levici se nelíbí podle nich nedostatečné odstraňování nenávistného obsahu, pravicově orientovaní uživatelé si zase stěžují na porušování svobody slova a stranění jejich oponentům. Řešení těchto a dalších sporů, navíc v globálním měřítku, může být pro Facebook do budoucna skutečně velmi náročné. To si myslí i profesor Roberts z kalifornské univerzity UCLA, který mluví o tom, že by se mohlo stát, že moderování obsahu bude hlavní činností zaměstnanců Facebooku.

Obavy z nevděčné role jakési internetové policie zřejmě sdílí i sám Mark Zuckerberg. Možná proto na jaře odeslal desítkám akademiků pozvánku na soukromou večeři ve svém domě. Několik se jich skutečně zúčastnilo. Pět účastníků, s nimiž server Motherboard hovořil, tvrdí, že tématem bylo právě moderování obsahu a to, jak k němu přistupovat. Akademici si pozvání prý váží, avšak někteří měli pocit, že je zakladatel příliš neposlouchá. Problém byl navíc prý s tím, že Zuckerberg silně věří, že lze najít funkční řešení pro moderování globální komunity podle jednotných standardů. To je ovšem něco, s čím zdaleka ne všichni oslovení experti souhlasí.

Anonymní zdroj seznámený s průběhem večeří řekl novinářům Motherboardu, že podle mnohých pozvaných byla pozvánka spíše jakousi deklarací toho, že Facebook mluví se „správnými lidmi“. Chybělo ale prý jakékoliv ujištění, že názory pozvaných budou reflektovány v budoucích pravidlech.