Chytří asistenti se v domácnostech objevují čím dál tím častěji. Zatímco v tuzemském prostředí jejich většímu rozšíření brání především jazyková bariéra, v zahraničí tato překážka odpadá. I přes poměrně velkou důvěru, kterou do chytrých asistentů vkládáme, je potřeba stále mít na paměti, že nejde o dokonalé produkty a že záludnosti lidského jazyka pro ně mohou občas být oříšek.

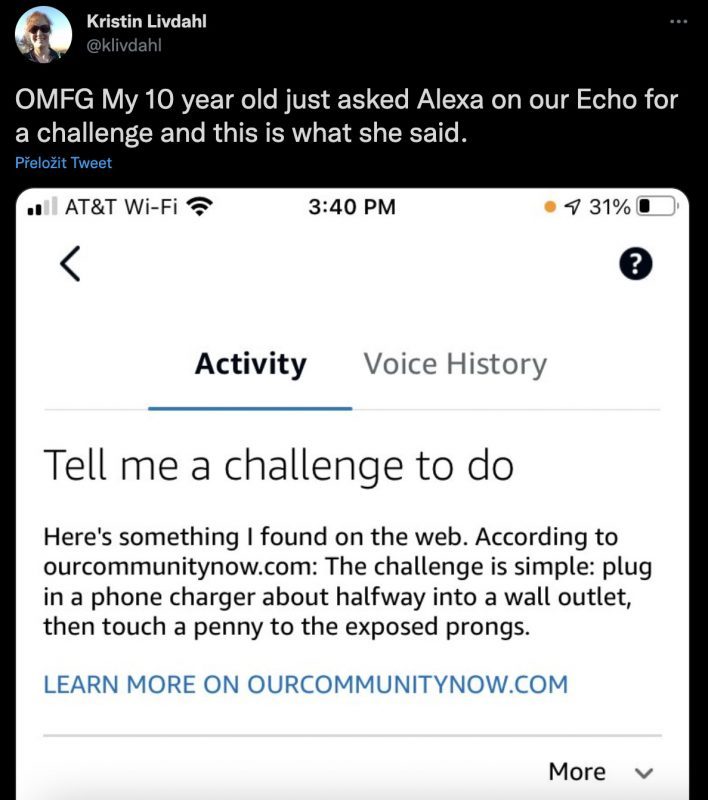

Poměrně závažný problém musela řešit společnost Amazon, která stojí za oblíbenou hlasovou asistentkou jménem Alexa. Její funkce „řekni mi výzvu“, která má za úkol dávat zajímavé výzvy především dětem, mohla dopadnout tragicky. Když se desetileté dítě Kristin Livdahlové zeptalo jejich chytrého reproduktoru Echo na výzvu, kterou by mohlo splnit, odpověď Alexy Livdahlovou šokovala.

Alexa totiž jejímu dítěti přečetla výsledek vyhledávání na webu. Na tom by nebylo nic až tak nebezpečného, kdyby Alexa místo neškodné výzvy nezačala citovat článek, který popisuje nebezpečný trend šířící se na TikToku, jenž potenciálně mohl její dceru stát život. Konkrétně Alexa jejímu dítěti poradila, aby „zapojila nabíječku od telefonu zhruba do poloviny do elektrické zásuvky a pak se dotkla kovovou mincí odkrytých kolíků.“

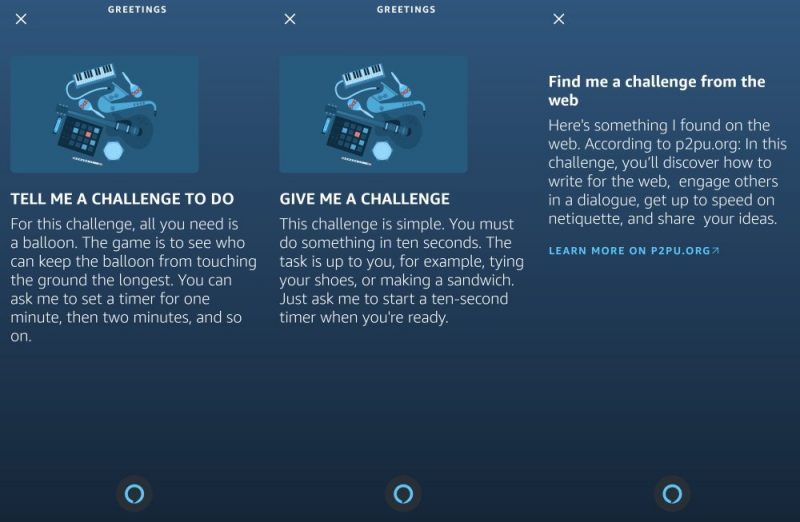

Amazon na celou situaci zareagoval poměrně rychle a celou funkci raději dočasně zablokoval, aby ji mohl opravit. Pokud nyní požádáte Alexu o výzvu, dostanete odpověď, která by neměla ohrozit lidský život. Redaktoři serveru The Verge se pokusili z Alexy znovu získat stejný či alespoň podobný výsledek, nicméně se jim to nepodařilo, stejně jako nám v redakci.

Chytří asistenti mají problém s porozuměním kontextu

Nejedná se o první případ, kdy chytrý asistent selhal v posouzení kontextu a poskytl uživateli potenciálně nebezpečnou radu. V říjnu poukázal jeden uživatel na Twitteru na výsledek Assistanta od Googlu, který na dotaz „co dělat, když má někdo záchvat“, odpověděl na základě článku, který popisoval přesný opak. Také v tomto případě Google zareagoval rychle a uživatelé už nyní dostanou správný výsledek.